Roboter einfach trainieren – multimodale KI macht’s möglich

von Roboterwelt Redaktion 17. Juli 2025

Mit einem neuen Interface öffnen Forschende des MIT die Tür zur intuitiven Roboterprogrammierung – ganz ohne Code. Wie multimodales Lernen die Interaktion zwischen Mensch und Maschine revolutioniert.

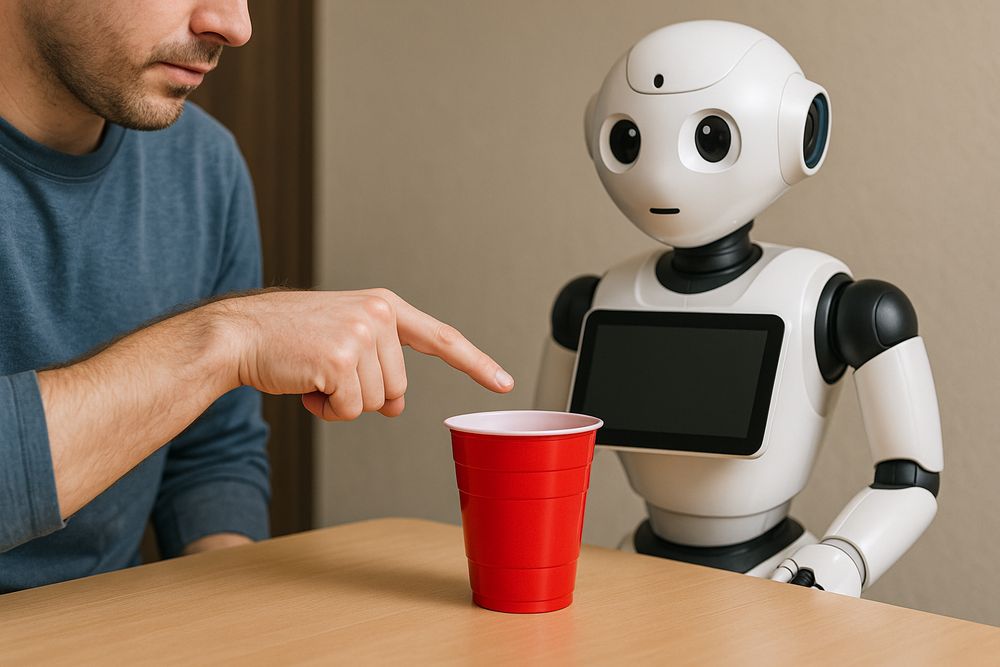

Ein Interface für alle: Roboter lernen durch Zeigen, Sprechen, Anfassen

Roboter waren lange das Spielfeld technisch versierter Spezialistinnen und Spezialisten. Erst durch neue Ansätze im Bereich des maschinellen Lernens beginnt sich das Blatt zu wenden. Ein aktuelles Beispiel dafür liefert das Massachusetts Institute of Technology (MIT): Die dort entwickelte Trainingsplattform erlaubt es, Serviceroboter mithilfe natürlicher Sprache, physischer Demonstrationen und visueller Hinweise direkt zu unterweisen.

Statt komplexem Code genügt jetzt ein einfacher Befehl wie „Stelle den roten Becher auf den Tisch“, begleitet von einer Geste oder Bewegung. Der Clou: Der Roboter versteht über multimodale Verknüpfung von Sprach-, Bild- und Sensordaten, was gemeint ist – und setzt es um.

Die zugrundeliegende Technologie basiert auf „SALI“, einem fortschrittlichen Lernmodell, das mit einem integrierten Datensatz aus Bildern, Sprache und Roboterdaten trainiert wurde. Damit ist das System fähig, auch aus wenigen Beispielen zu lernen und neue Aufgaben zu adaptieren.

Im Detail: Was das neue MIT-System auszeichnet

Das Tool der MIT-Forschenden stützt sich auf mehrere Schlüsselelemente, um Robotertraining für alle zugänglich zu machen:

Dabei profitieren die Modelle vom aktuellen Stand der Forschung im Bereich multimodaler Transformer. Modelle wie CLIP, Flamingo oder PaLM-E dienen als technische und konzeptionelle Grundlage.

Die folgende Tabelle zeigt zentrale Merkmale:

| Merkmal | Funktion |

|---|---|

| Sprachverarbeitung | Erkennung & Interpretation natürlichsprachlicher Befehle |

| Visuelle Objekterkennung | Klassifikation & Lokalisierung von Zielobjekten |

| Haptische Demonstration | Übertragung menschlicher Bewegungen an den Roboter |

| Adaptives Lernen | Lernfähigkeit ohne erneutes Training von Grund auf |

Crossover von Mensch und Maschine: Multimodales Lernen

Was das MIT-System besonders macht, ist die Integration unterschiedlicher Wahrnehmungskanäle. Diese multimodale Herangehensweise orientiert sich stark an kognitiven Prozessen beim Menschen. In der Kognitionsrobotik spricht man hier von sogenannter „Embodied AI“. Der Roboter handelt nicht allein auf Basis formaler Programmierung, sondern lernt aus Erfahrung – körperlich und situativ.

Besonders relevant ist dabei das Konzept „Learning from Demonstration“ (LfD). Menschen zeigen dem Roboter, was zu tun ist. Dieser überführt die Bewegung in eine abstrahierte Handlungsstrategie. Unterstützt durch große vortrainierte KI-Modelle kann der Roboter so selbst generalisieren.

Beispiele hierfür:

Google DeepMind PaLM-E: Sprach-, Bild- und Robotikdaten in einem Modell verschränkt

RT-2: Verknüpft Webdaten mit robotischen Handlungen

Open-Source-Ansätze für Low-Cost-Robotik: gestengestützte Steuerung auf DIY-Systemen

Potenziale mit gesellschaftlicher Tragweite

Ein solch niederschwelliger Zugang zur Roboterprogrammierung könnte weit mehr bewirken als nur technische Vereinfachung. Möglich werden:

Die Demokratisierung von Robotik hebt sie aus isolierten Laborumfeldern in offenere Anwendungsfelder. Sie öffnet die Tür für kreative, kollaborative Formen des Trainings – ganz ähnlich wie No-Code-Ansätze im Softwarebereich.

Aber: Risiken durch Missverständnisse und Fehlanwendungen

Trotz aller Vorteile sind Herausforderungen nicht zu unterschätzen:

Sprachmodelle unterliegen potenziellen Verzerrungen (Bias)

Fehlinterpretationen durch den Roboter können physisch gefährlich sein

Verantwortungsklären bei fehlerhaftem Verhalten sind juristisch ungeklärt

Begrenzte Generalisierungsfähigkeit in unbekannten Kontexten

Diese Herausforderungen müssen schon während der Entwicklung adressiert werden. Transparenz, Nachvollziehbarkeit und Sicherheit bei Mensch-Roboter-Interaktionen gehören ins Zentrum der Forschung.

Ausblick: Intuitive KI braucht den Menschen

Roboter, die durch Zeigen und Sprechen lernen, markieren einen Paradigmenwechsel. Sie ersetzen klassische Programmierung nicht – aber sie erweitern sie um eine bedeutungsoffene, menschzentrische Interaktionsschicht.

Die Zukunft liegt womöglich in hybriden Systemen, bei denen der Mensch als kontinuierlicher Trainer Teil des Regelmechanismus bleibt. Shared Autonomy, Just-in-Time-Guidance oder AR-unterstütztes Training sind vielversprechende Konzepte.

Das unmittelbare Fazit: Nicht nur Experten, sondern auch kreative Laien können Roboter künftig trainieren – sofern Interface, Ethik und Technik zusammenspielen.

-

Forschende des MIT haben ein neues Trainingssystem für Roboter entwickelt, das natürliche Sprache, visuelle Hinweise und physische Gesten kombiniert.

Die multimodale Plattform erlaubt es, Roboter auf neue Aufgaben zu trainieren – ganz ohne Programmierkenntnisse. Im Zentrum steht das Lernmodell „SALI“, das kontextbezogene Anweisungen aus wenigen Beispielen versteht.

Diese Entwicklung eröffnet neue Potenziale für Alltag, Industrie und Bildung, bringt aber auch ethische und sicherheitstechnische Fragen mit sich. Multimodales Lernen könnte zur Schlüsseltechnologie der nächsten Robotikgeneration werden.

-