Warum leistungsfähige KI extrem viel Rechenpower braucht

von Roboterwelt Redaktion 28. Juli 2025

Massive KI-Modelle wie ChatGPT, Claude und Gemini treiben Innovation voran. Doch ihr Hunger nach Rechenleistung wächst exponentiell – mit Konsequenzen für Technik, Umwelt und Gesellschaft. Was hinter dem Megatrend steckt, zeigt eine fundierte Analyse.

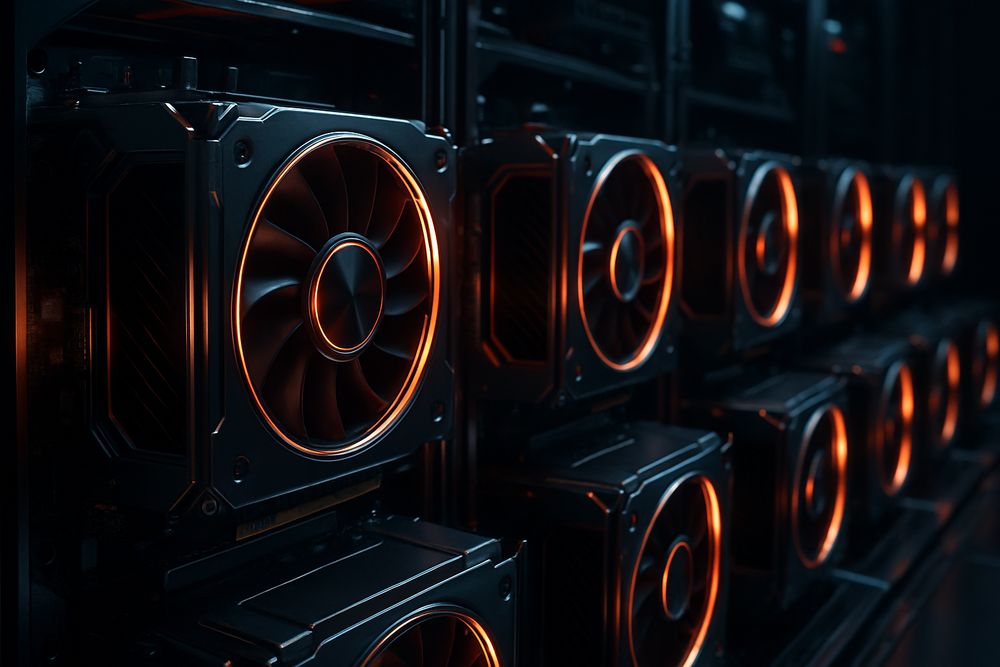

Rechenleistung als Schlüssel zur nächsten KI-Generation

Die Entwicklung großer Sprachmodelle verläuft nicht linear, sondern skaliert mit immensen Ressourcen. Unternehmen wie Anthropic, OpenAI und Google DeepMind setzen auf immer größere KI-Modelle, die nur mit einer exponentiell steigenden Rechenkapazität trainiert und validiert werden können.

Dabei geht es nicht nur um Performancegewinne, sondern auch um Sicherheit: Je leistungsfähiger ein Modell, desto komplexer wird seine Kontrolle – und desto mehr Infrastruktur wird für dessen Erforschung benötigt.

Zentrale Studien der letzten Jahre zeigen, dass Sprachmodelle mit steigender Anzahl von Parametern, Daten und Rechenkapazität signifikant besser werden. Das sogenannte "Chinchilla Paper" von DeepMind (2022) und OpenAIs Skalierungsgesetze (Kaplan et al., 2020) formulieren das Verhältnis mathematisch:

Leistung ≈ (Modellgröße)^–α × (Datenmenge)^–β × (Compute)^–γ

Die Folge: Wer an der Spitze der KI-Entwicklung bleiben will, muss exponentiell in Rechenressourcen investieren. Effizienztricks wie sparsity, quantization oder Mixture-of-Experts können helfen, den Hunger zu zähmen – beseitigen ihn aber nicht.

Als führendes Unternehmen im Bereich sicherheitsorientierter KI argumentiert Anthropic, dass nicht nur das Modelltraining, sondern auch die Sicherheitsanalyse enorm viel Rechenleistung braucht. Komplexe Tests auf Robustheit, Alignment und unerwünschte emergente Fähigkeiten sind ressourcenintensiv – teils auf dem Niveau der eigentlichen Trainingsprozesse.

Ohne Zugang zu sogenannten "Frontier Models" lassen sich kritische Forschungsthemen wie goal misgeneralization, deception oder interpretierbare Repräsentationen nicht sinnvoll evaluieren. Anthropic fordert daher Supercomputer mit über 200.000 KI-GPUs speziell für sicherheitsfokussierte Experimente.

Aktuelle High-End-Infrastrukturen entstehen fast ausschließlich im Umfeld von Big Tech. Die folgende Übersicht zeigt einige der bedeutendsten KI-Cluster (Stand 2025):

| Anbieter | Systemname | Plattform/Chips | Erwartete GPUs |

|---|---|---|---|

| Microsoft/OpenAI | Azure AI Supercomputer | Nvidia H100 | 10.000–50.000 |

| Amazon | AWS Bedrock Cluster | Trainium/Inferentia | Nicht spezifiziert |

| Google DeepMind | Gemini Cluster | TPUv5 (Trillium) | >250 ExaFLOPs |

| xAI (Musk) | Grok-3 Compute Umgebung | Nvidia H100 | 100.000 geplant |

| Anthropic | Claude Infrastructure (AWS) | Nvidia H100 + TPUs | >200.000 geplant |

Damit rückt ein zentrales Problem ins Licht: Der Zugang zur leistungsfähigsten Hardware konzentriert sich auf wenige Player – mit weitreichenden Konsequenzen für Wissenschaft, Markt und globale KI-Governance.

Vorteile massiver Compute-Skalierung:

Ermöglicht die nächsten Entwicklungssprünge leistungsstarker Sprachmodelle

Voraussetzung für Sicherheitsforschung auf Frontier-Niveau

Nur mit entsprechender Infrastruktur lassen sich neue Risiken zuverlässig erkennen

Kritikpunkte an der Eskalation:

Energie- und Wasserverbrauch von Rechenzentren wird alarmierend hoch (vgl. MIT 2024)

Fortschritte werden teurer, Nutzenzuwachs aber geringer (Stichwort: diminishing returns)

Offenes Forschen wird durch Infrastruktur-Oligopole massiv erschwert (DAIR, 2024)

Die Debatte ist längst globalpolitisch aufgeladen und betrifft Exportkontrollen, Wettbewerbsfragen und ethische Dimensionen wie Zugangsgerechtigkeit oder KI-Souveränität von Staaten.

Trotz des Hypes um GPU-Ausbau mehren sich Stimmen, die auf smartere Alternativen drängen. Gefordert werden:

Effizientere Algorithmen mit sparsity oder Retrieval-Augmented Generation (RAG)

Hybridmodelle mit modularen oder symbolischen Komponenten

Adaptive Systeme, die edge-basiert oder verteilt lernen und arbeiten

Außerdem zeigt sich: Viele KI-Aufgaben brauchen kein GPT-5. Kleinere, spezialisierte Modelle können im Alltag robuster und ressourcenschonender agieren – unter anderem im Bildungsbereich, auf lokalen Geräten oder für Open-Source-Communities.

Die Dominanz großer Akteure führt zu kritischer Infrastrukturkonzentration. Einige Think Tanks und Wissenschaftsnetzwerke fordern daher:

Öffentliche Supercomputer für Forschung und Bildung

Fairen Zugang zu Trainingsdaten und Benchmarks

Umweltschutzauflagen für Rechenzentren

Stärkere Regulierung von Compute-Kapazitäten zur KI-Entwicklung

Beispiele wie die EU AI Factories oder die geplante NIST AI Compute Grid zeigen, dass Staaten reagieren – doch oft spät und zögerlich.

Der Zusammenhang zwischen Rechenleistung und KI-Fähigkeit ist nachgewiesen. Sicherheit, Interpretierbarkeit und Leistungsfähigkeit profitieren stark von hochskalierter Infrastruktur – wie von Anthropic betont.

Doch der Fokus allein auf GPU-Massen ist riskant. Fortschritt entsteht nicht nur durch mehr, sondern auch durch bessere Nutzung bestehender Ressourcen. Und vor allem: durch offenen Zugang, kooperative Entwicklung und nachhaltige Technikpolitik.

-

Große Sprachmodelle wie Claude oder ChatGPT benötigen exponentiell wachsende Rechenleistung – nicht nur für Training, sondern auch für Sicherheitsforschung. Anthropic betont, dass sichere KI-Systeme nur durch Zugang zu massiver Infrastruktur möglich seien. Doch der GPU-Wettlauf wirft kritische Fragen auf: Wer kontrolliert die Technologie? Wie nachhaltig ist der Energieverbrauch? Und wie fair bleibt der Zugang zu moderner KI? Fortschritt braucht nicht nur Power, sondern auch Verantwortung.

-